在部署一套使用Dify作为开发平台的AI应用时,发现两个Bug:

1. Vllm、OpenAI-API-compatible等插件无法返回生成内容

2. 插件XInference生成中异常中断

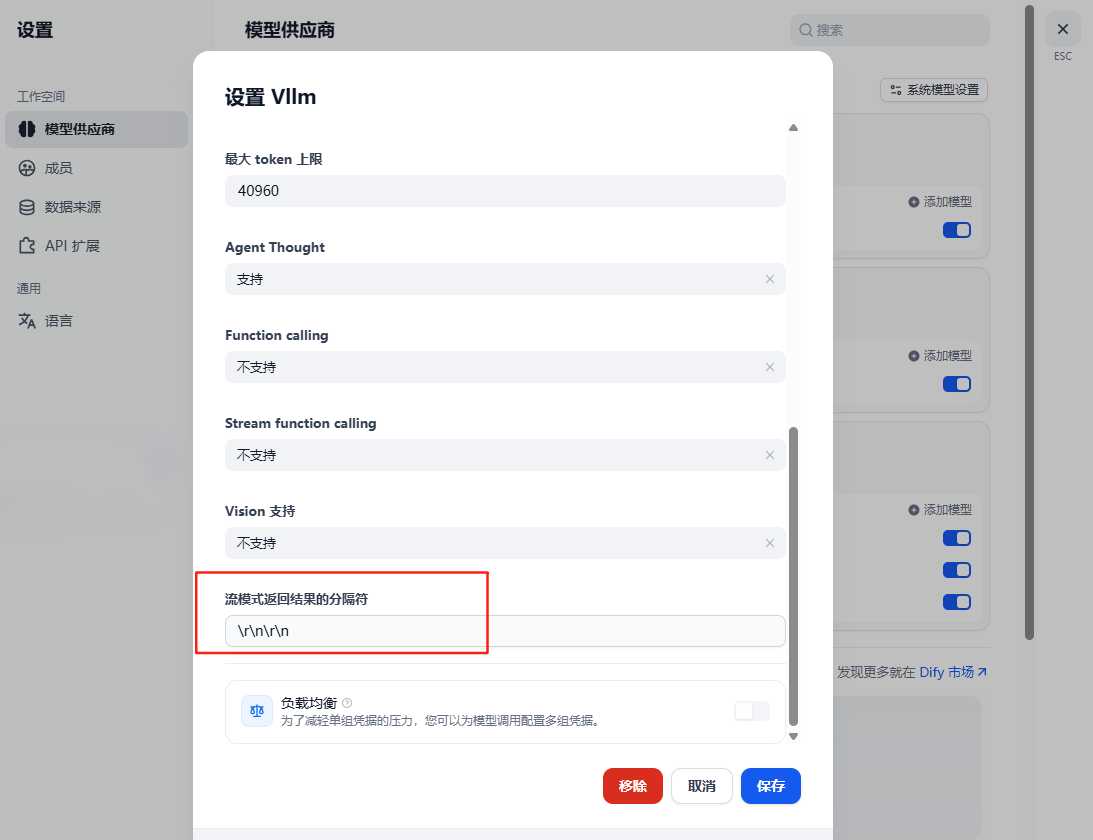

排查发现:因为模型是内网中自己用XInference部署的Deepseek R1,所以流模式返回结果的分隔符默认值和之前用公有模型API调试时不一样,需要将前述插件的流模式返回结果的分隔符默认值\n\n改为XInference特有的\r\n\r\n。这样可以解决第一个bug。

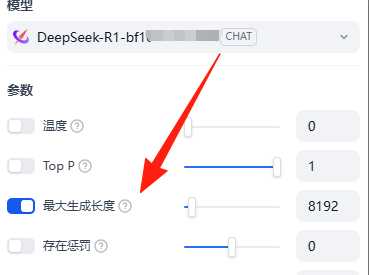

关于插件XInference生成中异常中断的问题,则排查到是因为XInference插件默认输入数仅512,需要手动设置最大输出。